韩国科学技术研究院机械工程系视觉智能实验室(韩国大田; www.kaist.ac.kr/kr)开发了一种新的多视角立体方法,称为EOMVS,它使用全向事件摄像机来重建具有宽视场的3D场景。

基于事件的图像传感器仅记录像素强度的变化。根据研究人员的说法,基于事件的相机的这种独特性质使得基于RGB帧的图像(包括全向图像)的传统计算机视觉算法无法应用。因此,研究人员需要一种独特的算法来处理基于事件的图像,并使其能够用于同步定位和映射(SLAM)或视觉里程(VO)应用。

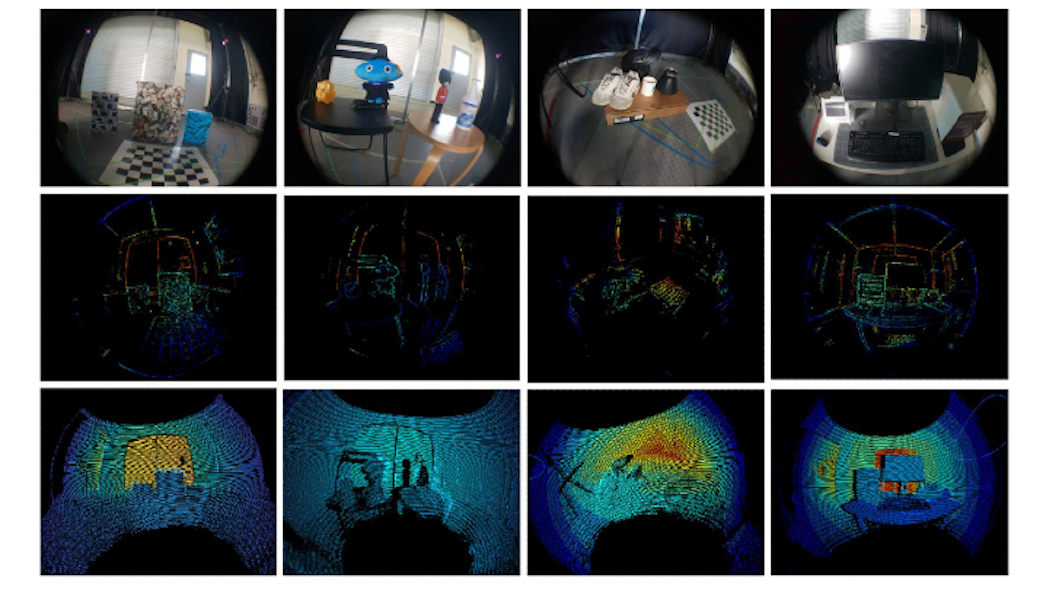

为了创建一个用于实验的真实数据集,研究人员使用了来自iniVation(瑞士苏黎世; www.inivation.com)具有640×480分辨率。使用C接口适配器将Entaniya(www.entaniya.co.jp)鱼眼M12镜头连接到事件摄像机,使摄像机的视场角高达180°。由NaturalPoint开发的OptiTrack系统(www.naturalpoint.com)已获取相机的姿势信息。

首先,研究人员使用一种累积方法创建了一种新的基于事件的相机校准技术,该方法定义了每个事件像素值和衰减函数的贡献程度。该技术可抑制可能转换为图像噪声的事件。

接下来,他们创建了一种方法,允许通过基于事件的全向图像进行深度估计。为每个参考视点(RV)构建视差空间图像(DSI),即体素网格。从房车上可以看到,该网格从附近的视点跟踪2D事件的投影光线进入3D空间。

具有最大光线交集的体素被认为最有可能占据场景中的3D点。高斯阈值从灰度图像创建二进制图像,创建了关于这些 3D 点位置的置信度图。置信图构成了半密集深度图和随附的3D点云的基础,这些三维点云叠加在原始全向图像上。

图像处理在一台采用英特尔酷睿 i7-10700 @ 2.90 GHz 8 核 CPU 处理器。针对使用Blender 3D图形软件创建的合成室内RGB和事件数据集进行测试,然后使用真实世界的图像进行测试。来自Ouster的OSI-128 3D LiDAR单元( www.ouster.com)获得地面真实深度图,以便与EOMVS方法创建的深度图进行比较。

相对误差在4.7%至9.6%之间,视场从145°增加到180°。研究人员现在计划为全向事件摄像机开发一种VO算法,以与EOMVS方法相结合,从而实现基于全向事件摄像机的SLAM应用。

暂无评论